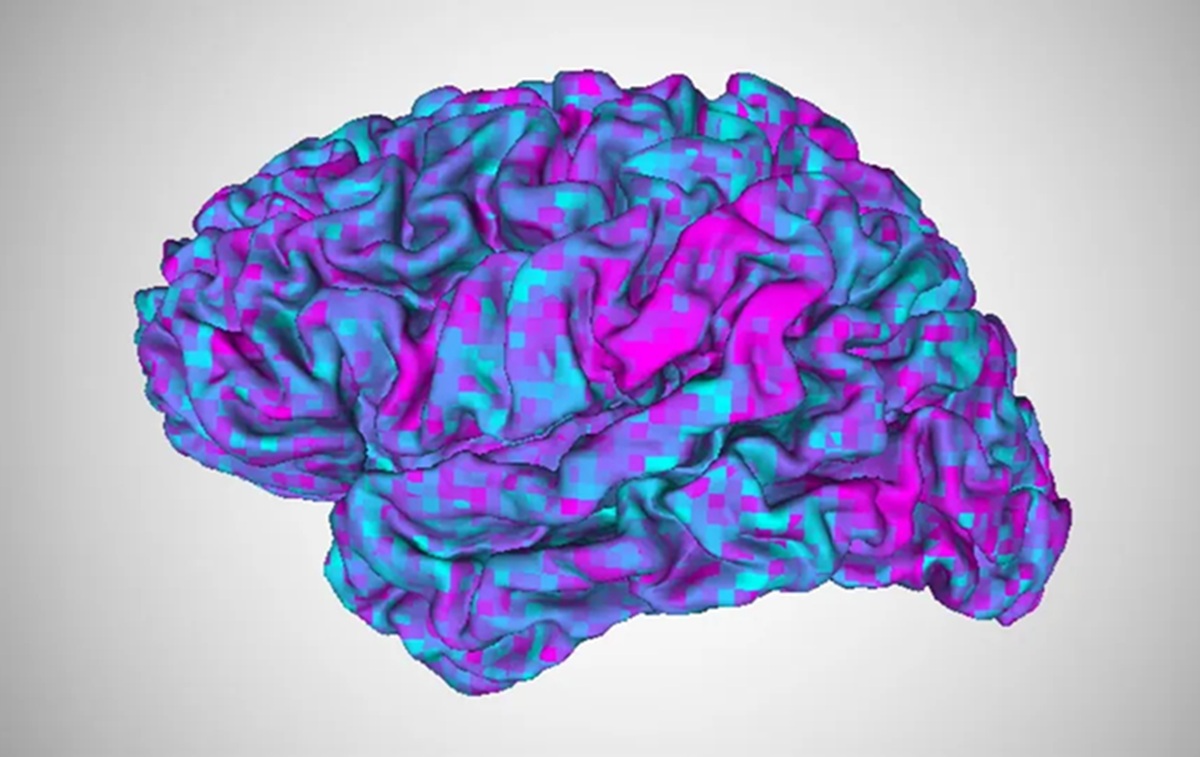

Para ilmuwan mengembangkan algoritma baru untuk "penerjemah otak" yang memanfaatkan kecerdasan buatan (AI) untuk mengubah pikiran menjadi teks.( Jerry Tang/University of Texas at Austin)

Para ilmuwan mengembangkan algoritma baru untuk "penerjemah otak" yang memanfaatkan kecerdasan buatan (AI) untuk mengubah pikiran menjadi teks.( Jerry Tang/University of Texas at Austin)

PARA ilmuwan membuat perbaikan baru pada "penerjemah otak" yang menggunakan kecerdasan buatan (AI) untuk mengubah pikiran menjadi teks.

Algoritma konverter baru mereka dapat melatih penerjemah yang sudah ada dengan cepat pada otak orang lain, kata tim tersebut dalam sebuah studi terbaru. Temuan ini suatu hari nanti dapat mendukung orang dengan afasia, gangguan otak yang memengaruhi kemampuan seseorang untuk berkomunikasi, kata para ilmuwan.

Penerjemah otak menggunakan pembelajaran mesin untuk menerjemahkan pikiran seseorang menjadi teks, berdasarkan respons otak mereka terhadap cerita yang mereka dengarkan. Namun, iterasi sebelumnya dari penerjemah tersebut mengharuskan peserta untuk mendengarkan cerita di dalam mesin MRI selama berjam-jam, dan penerjemah ini hanya berfungsi untuk individu yang dilatih.

"Orang dengan afasia sering kali mengalami kesulitan memahami bahasa serta menghasilkan bahasa," kata Alexander Huth, seorang ahli neuroinformatika di Universitas Texas di Austin (UT Austin) yang juga merupakan penulis studi ini. "Jadi, jika itu yang terjadi, kita mungkin tidak bisa membangun model untuk otak mereka sama sekali dengan hanya melihat bagaimana otak mereka merespons cerita yang mereka dengarkan."

Dalam penelitian yang diterbitkan pada 6 Februari di jurnal Current Biology, Huth dan rekan penulis Jerry Tang, seorang mahasiswa pascasarjana di UT Austin, menyelidiki bagaimana mereka bisa mengatasi keterbatasan ini. "Dalam penelitian ini, kami bertanya, dapatkah kami melakukan hal-hal secara berbeda?" kata Huth. "Dapatkah kami pada dasarnya mentransfer penerjemah yang kami bangun untuk otak seseorang ke otak orang lain?"

Para peneliti pertama-tama melatih penerjemah otak pada beberapa peserta referensi dengan cara yang lama, dengan mengumpulkan data fMRI fungsional saat peserta mendengarkan 10 jam cerita radio.

Kemudian, mereka melatih dua algoritma konverter pada peserta referensi dan pada set peserta "tujuan" yang berbeda: satu menggunakan data yang dikumpulkan saat peserta mendengarkan cerita radio selama 70 menit, dan yang lainnya saat mereka menonton film pendek Pixar tanpa suara yang tidak terkait dengan cerita radio.

Menggunakan teknik yang disebut functional alignment, tim memetakan bagaimana otak peserta referensi dan tujuan merespons cerita audio atau film yang sama. Mereka menggunakan informasi tersebut untuk melatih penerjemah agar bekerja dengan otak peserta tujuan, tanpa perlu mengumpulkan data pelatihan selama berjam-jam.

Selanjutnya, tim menguji penerjemah menggunakan cerita pendek yang belum pernah didengar sebelumnya oleh para peserta. Meskipun prediksi penerjemah sedikit lebih akurat untuk peserta referensi asli daripada yang menggunakan konverter, kata-kata yang diprediksi dari pemindaian otak masing-masing peserta tetap terkait secara semantik dengan kata-kata yang digunakan dalam cerita uji coba.

Misalnya, salah satu bagian dari cerita uji mencakup seseorang yang membahas pekerjaan yang tidak mereka nikmati, mengatakan, "Saya seorang pelayan di kedai es krim. Jadi, um, itu tidak... saya tidak tahu di mana saya ingin berada, tapi saya tahu itu bukan itu."

Penerjemah yang menggunakan algoritma konverter yang dilatih pada data film memprediksi: "Saya berada di pekerjaan yang saya rasa membosankan. Saya harus mengambil pesanan dan saya tidak menyukainya, jadi saya mengerjakannya setiap hari." Bukan kecocokan yang persis — penerjemah tidak membacakan suara yang tepat seperti yang didengar orang, kata Huth — tetapi ide-idenya terkait.

"Hal yang benar-benar mengejutkan dan keren adalah kita bisa melakukan ini meskipun tidak menggunakan data bahasa," kata Huth kepada Live Science. "Jadi, kita bisa memiliki data yang kita kumpulkan hanya saat seseorang menonton video diam, dan kemudian kita bisa menggunakan itu untuk membangun penerjemah bahasa untuk otak mereka."

Menggunakan konverter berbasis video untuk mentransfer penerjemah yang sudah ada ke orang dengan afasia mungkin membantu mereka mengekspresikan pikiran mereka, kata para peneliti. Ini juga mengungkapkan beberapa tumpang tindih antara cara manusia merepresentasikan ide dari bahasa dan dari narasi visual di otak.

"Studi ini menunjukkan bahwa ada representasi semantik yang tidak peduli dari mana modalitas itu berasal," kata Yukiyasu Kamitani, seorang ahli neuroinformatika di Universitas Kyoto yang tidak terlibat dalam penelitian ini. Dengan kata lain, ini membantu mengungkap bagaimana otak merepresentasikan konsep-konsep tertentu dengan cara yang sama, meskipun disajikan dalam format yang berbeda.

Langkah selanjutnya bagi tim adalah menguji konverter pada peserta dengan afasia dan "membangun antarmuka yang akan membantu mereka menghasilkan bahasa yang ingin mereka hasilkan," kata Huth. (Live Science/Z-2)

3 weeks ago

11

3 weeks ago

11